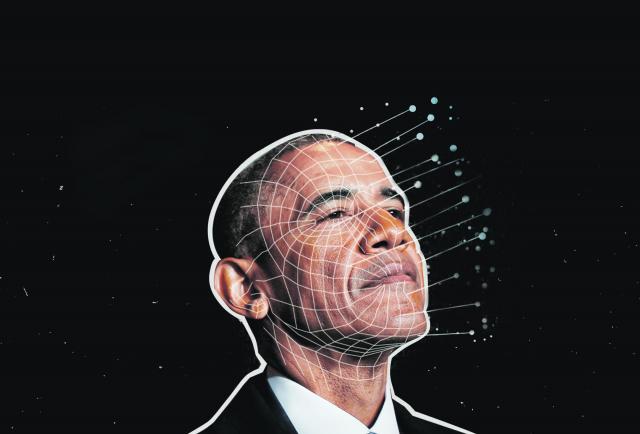

Bireysel zekanın doruklarına ulaştıran yapay zeka teknolojisi, belki henüz insanı birebir kopyalamıyor ama artık insan yüzünü inanılmaz yüksek bir inandırıcılıkta dijital olarak kopyalayıp, canlandırabiliyor. Deepfake de yapay zekanın “derin öğrenme” ve “gerçek dışı gerçeklik üretebilme” yeteneğinin bir ürünü olarak tehdit oluşturuyor.

Gülsüm YILDIRIM/HERKES DUYSUN

BURSA (İGFA) - Deepfake teknolojisi adını 2000’li yılların en gözde dijital platformlarından reddit.com’daki "Deepfakes" lakaplı bir kullanıcıdan alıyor. Bu kullanıcı, yapay zeka teknolojisinin makine öğrenmesini içeren, genel kullanıma açılmış bir faceswap (yüz değiştirme) uygulamasını geliştirmeye odaklanınca, bu yeni teknolojinin de fitilini ateşlemiş oldu. Her ne kadar bu hesap daha sonra kapatılmış olsa da, kıvılcım bir yangına dönüşmüştü... Bu durumun riskleri ve kitleler üzerindeki etkisi hakkında Herkes Duysun’a açıklamalarda bulunan İstanbul Üniversitesi İletişim Fakültesi Halkla İlişkiler ve Tanıtım Bölümü Öğretim Üyesi Doç. Dr. Burcu Zeybek, “Siyasal iletişimi zorlaştırdığı gibi dezenformasyona da kapı açıyor.” dedi.

“DEEPFAKE VİDEOLAR SEÇMENLERİ KANDIRMAK ÜZERİNEDİR”

Kimlik avı saldırıları, uzun yıllardır var olan bir siber saldırı yöntemi olsa da halen kuruluşlara saldırmanın ve sızmanın en etkili yollarından biri olarak görülüyor. Son yıllarda kimlik avı saldırıları, yapay zeka teknolojilerinin siber suç yöntemi olarak kullanılmasıyla şekil değiştirdi. Bu yöntem, siber suçluların mağdurları alt etmek için kullandıklarını en etkili yollardan biri olarak görülüyor. Her geçen gün kendini yenileyen yapay zeka teknolojisi sayesinde, ses ve görüntü taklidiyle deepfake videoların karşımıza çıktığını belirten Doç. Dr. Burcu Zeybek, “Deepfake özelinde gelişen teknoloji, siyasal iletişimi de derinden etkiliyor. Siyasal iletişim açısından zorluk teşkil ettiği gibi dezenformasyona neden olan bu videolar makine öğrenimi sonucunda ortaya çıkmakta ve bir siyasi aktörün bir şeyi söylüyor ya da yapıyor gözükmesini sağlamaktadır. Gerçekte ise söz konusu kişi, ne böyle bir şeyi yapmış ne de söylemiştir. Pek çok konuşma örneği ve hareketli görüntüyü kullanmak şartıyla derin öğrenme algoritmaları ile oluşturulan deepfake videolar, seçmenleri kandırmak üzerine hazırlanmaktadır. Bu tip videolar rakip siyasetçiyi iyi bir skandala sürüklemek için ya da rakibin itibarını zedelemek için yapılabilir. Kaldı ki içinde yaşadığımız Post Truth çağı gerçeklerin, duygulardan ve kişisel inançlardan daha az etkili olduğu kanıtlanmıştır.” ifadelerini kullandı.

DEEPFAKE DÜNYANIN BAŞINI AĞRITTI

Deepfake teknolojisinin etkin biçimde kullanılabilmesi için birçok video, ses ve fotoğrafa ihtiyaç var. Siyasilerin ve ünlü kişiliklerin açık kaynaklardan ulaşılabilir pek çok ses ve görüntü kayıtları bulunduğundan çok daha kolay bir şekilde deepfake kurbanı oldukları görülüyor. Üretilen bu yalan içeriklerin gerçeklerinden ayırt edilebilmesi en azından medya profesyoneli olmayan kitleler için neredeyse imkansız.

Bu zamana kadar da birden fazla siyasi aktörün deepfake videosunun ortaya çıktığını belirten Zeybek bu kişilerin isimlerini şöyle sıraladı:

“2018 yılında Eski ABD başkanı Barrack Obama’nın, Vlademir Putin, Kuze Kore Lideri Kim Jong’un, İngiltere Kralçiesi II. Elizabeth’in, Belçika Başkabakanı Sophie Vilmes’in deepfake videoları çıkmıştır.”

ulusalbasinajansi.com web sitesinde yayınlanan haber, resim, bilgi, belge, metin, video niteliğindeki tüm yazılaı ve görsel eserler Türkiye Cumhuriyeti Yasalarına tamamen uygun olarak yayınlanmaktadır. TC 5846 sayılı Fikir ve Sanat Eserleri Kanunu'nun telif haklarına ilişkin hükümlerine ve AB Fikri Mülkiyet Hukukuna göre Ulusal Basın Ajansı'.com'un yazılı izni olmadıkça hiçbir kimse, yayıncı ve kuruluş, herhangi bir eserin tamamını veya bir kısmını yayınlayamaz, çoğaltamaz, alıntı yapamaz